La hipótesis de Riemann (HR en lo que sigue) afirma que los ceros complejos de la función \(\zeta(s)\) están todos en la recta \(\Re(s)=\frac12\). Hay tres resultados básicos en la dirección de probar la HR:

- Hardy en 1914 consiguió probar que había infinitos ceros en esa recta.

- Ingham en 1940 probó que la mayoría de los ceros están próximos a dicha recta.

- Levinson en 1974 probó que al menos 1/3 de los ceros están en la recta.

Cada uno de estos pasos han sido mejorados ligeramente en el transcurso de los años, salvo el resultado de Ingham. Hasta este mayo en que James Maynard y Larry Guth han conseguido superar la marca que Ingham había establecido hace 84 años.

Los primos y la hipótesis de Riemann

La HR es importante por su conexión con los números primos. Pero no es una caja mágica. Hay muchas cuestiones sobre primos que quedarían abiertas incluso si demostramos la HR. Una de las preguntas que sí resuelve se refiere al número de primos en intervalos pequeños \([x,x+y]\). Si \(y\) no es muy grande, la probabilidad de que un número del intervalo sea primo es \(1/\log x\). Por tanto esperamos encontrar \(y/\log x\) primos en ese intervalo.

El postulado de Bertrand dice que en el intervalo \([x,2x]\) (con \(x>1\)) siempre hay un primo. Fue probado por Chebyshev en 1852 por métodos elementales. Nos referimos a \(y\) bastante más pequeños que \(x\).

Admitiendo HR se prueba que $$\# \{p\in [x,x+y], p \text{ primo}\}=(1+o(1))\frac{y}{\log y} \text{ siempre que } x^{\frac12+\varepsilon}\le y\le x.$$ \(o(1)\) denota una función de \(x\) que tiende a cero para \(x\to+\infty\)

Pero no es necesaria aquí toda la fuerza de la hipótesis de Riemann. En su lugar basta saber que los ceros fuera de la recta crítica no son demasiados. Para ponerlo en forma precisa para \(\sigma>1/2\) y \(T>0\), sea \(N(\sigma,T)\) el número de ceros \(\rho=\beta+i\gamma\) de \(\zeta(s)\) con \(0<\gamma\le T\) y \(\beta>\sigma\). La HR es equivalente a decir que \(N(\sigma,T)=0\) para cualesquiera \(\sigma>1/2\) y \(T>0\). La conexión con los primos en intervalos pequeños es el siguiente Lema.

Lema. Si existe una constante \(A>0\) tal que \(N(\sigma,T)\le T^{(A+o(1))(1-2\sigma)}\), entonces $$\# \{p\in [x,x+y], p \text{ primo}\}\le (1+o(1))\frac{y}{\log x}$$ siempre que \(x^{1-\frac{1}{A}+\varepsilon}\le y\le x\).

Según este lema conseguiríamos tanto como con la HR si probáramos la hipótesis de densidad, es decir, que la desigualdad anterior para \(N(\sigma,T)\) vale para \(A=2\) $$\textbf{HD}:\qquad N(\sigma,T)\le T^{(2+o(1))(1-2\sigma)}.$$ La palabra densidad aquí se debe a que estamos acotando la densidad de ceros de \(\zeta(s)\) contenidos en cajas del tipo \([\sigma,1]\times[0,T]\).

Teoremas de densidad hasta Mayo de 2024

No sabemos probar la hipótesis de densidad pero lo que si podemos es probar desigualdades del tipo $$N(\sigma,T)\le T^{(A+o(1))(1-2\sigma)}$$ que, como hemos visto en el Lema, implican resultados sobre primos en intervalos pequeños. Destacamos dos avances en esa dirección \begin{align*} N(\sigma,T)\le T^{\frac{3(1-\sigma)}{2-\sigma}+o(1)}\qquad \textrm{Ingham (1940)}\\ N(\sigma,T)\le T^{\frac{3(1-\sigma)}{3\sigma-1}+o(1)}\qquad \textrm{Huxley (1972)}\end{align*} Es fácil ver que ambos resultados son iguales para \(\sigma=3/4\), siendo el de Ingham mejor para \(\sigma<3/4\) y el de Huxley para \(\sigma>3/4\).

Combinando los dos se obtiene que $$N(\sigma,T)\le T^{\frac{12}{5}(1-\sigma)+o(1)}.$$ Lo que implica que $$\# \{p\in [x,x+y], p \text{ primo}\}\le (1+o(1))\frac{y}{\log x}$$ siempre que \(x^{\frac{7}{12}+\varepsilon}\le y\le x\).

Esencialmente esto es lo que se sabía hasta Mayo de 2024. Hay que decir que para \(\sigma\le 3/4\) el resultado de Ingham sigue siendo lo mejor que sabíamos, en cambio el resultado de Huxley para \(\sigma>3/4\) sí se había conseguido mejorar. La única manera que tenemos de mejorar los resultados sobre primos en intervalos pequeños es mejorar el resultado de Ingham.

Polinomios de Dirichlet

¿Cómo probamos cotas para \(N(\sigma,T)\)? Usaremos polinomios de Dirichlet. Un polinomio de Dirichlet \(D(t)\) es una función de la forma $$D_N(t)=\sum_{n=N+1}^{2N}a_n e^{-it\log n}=\sum_{n=N+1}^{2N} \frac{a_n}{n^{it}},\qquad |a_n|\le 1.$$ La conexión de los polinomios con el teorema de densidad se expresa en el siguiente lema.

Lema. La cantidad \(N(\sigma,T)\) está acotada por $$\sup_{\substack{D_N(t)\\W\subset[0,T]}}\# W,$$ donde \(W\) es un conjunto de puntos \(t_j\) que están \(1\)-separados (esto es \(|t_j-t_k|\ge1\) para \(j\ne k\)) y donde el polinomio de Dirichlet toma valores grandes \(|D(t_j)|>N^\sigma\).

El supremo varia sobre todas las parejas \((D_N(t), W)\), donde el polinomio de Dirichlet \(D_N(t)\) tiene longitud \(T^{1/100}\le N\le T^{1/2}\) y todos los conjuntos \(W\) de puntos \(1\)-separados y en donde el correspondiente polinomio es grande.

Nuestro problema es entonces determinar cual es el supremo de \(\#W\) en términos de \(N\), \(\sigma\), y \(T\). Esperamos que se cumpla la

Conjetura de Montgomery: Se tiene \(\#W\le T^{o(1)} N^{2-2\sigma}\) para \(\sigma>\frac12\).

La conjetura de Montgomery implica la hipótesis de densidad. Obviamente la conjetura de Montgomery no la tenemos. Lo que tenemos son dos cotas complementarias \begin{align*} \#W&\le T^{o(1)}(TN^{1-2\sigma}+N^{2-2\sigma}),\\ \#W&\le T^{o(1)}(TN^{4-\sigma}+N^{2-2\sigma}).\end{align*} La primera es la Acotación del valor medio y la segunda Acotación de los valores grandes. La primera es mejor cuando \(\sigma< 3/4\) y la segunda para \(\sigma>3/4\), y de ellas se siguen los resultados de Ingham y Huxley respectivamente.

Lo que necesitamos es mejorar esto en un intervalo que contenga al punto \(\sigma=3/4\) y este es el teorema que James Maynard y Larry Guth acaban de probar:

Teorema. Se tiene la acotación $$\#W\le T^{o(1)}(N^{2-2\sigma}+N^{\frac{18}{5}-4\sigma}+T N^{\frac{12}{5}-4\sigma}).$$

Este resultado mejora los dos anteriores para \(\frac{7}{10}<\sigma<\frac{8}{10}\), en particular para el valor crítico \(\sigma=\frac{3}{4}\). El resultado de densidad correspondiente es $$N(\sigma,T)\le T^{\frac{30}{13}(1-\sigma)+o(1)}.$$ Y se sigue que $$\# \{p\in [x,x+y], p \text{ primo}\}\le (1+o(1))\frac{y}{\log x}$$ siempre que \(x^{\frac{17}{30}+\varepsilon}\le y\le x\).

La clave de la prueba

Un resultado como el que comentamos, que nadie ha podido hacerlo en 80 años, del que Tao confiesa haberlo intentado sin éxito, tiene que tener una prueba complicada. Podemos resumir el camino en usar adecuadamente el Álgebra lineal y el Análisis de Fourier.

Pensar el problema como un problema de álgebra lineal.

El resultado de Ingham para \(\sigma=3/4\) nos dice que \(N(3/4,T)\le T^{3/5}\). Lo que deseamos es rebajar el exponente \(3/5\).

Supongamos que tenemos un polinomio de Dirichlet \(D(t)=\sum_{n=N}^{2N}a_n n^{-it}\) con \(|a_n|\le 1\) y un conjunto \(W\subset[0,T]\) de puntos \(t_j\) bien separados y tales que \(|D(t_j)|>N^\sigma=N^{3/4}\). Queremos acotar el cardinal \(R\) de \(W\) en función de \(N\), \(T\), y \(\sigma=3/4\). Podemos considerar una matriz \(M\) de dimensión \(R\times N\) con entradas $$M=(n^{-it_j}).$$ Sea \(a\in \mathbf{C}^N\) el vector con coordenadas \((a_{N+1},a_{N+2},\dots, a_{2N})\). Podemos expresar que \(|D(t_j)|>N^{3/4}\) diciendo que el vector \(M a\) tiene sus \(R\) coordenadas \(>N^{3/4}\). Por tanto $$R N^{3/2}<\langle Ma, Ma\rangle=\langle M^*Ma, a\rangle\le \Vert M^*M\Vert\Vert a\Vert^2\le N\Vert M^*M\Vert.$$ Se sigue que $$R\le \Vert M^*M\Vert N^{-1/2}.$$ Si probamos \(\Vert M^*M\Vert\le T^{11/10}\), tendríamos el resultado de Ingham. Necesitamos probar \(\Vert M^*M\Vert\le T^{r}\) con \(r<11/10\).

El valor de \(\Vert M^*M\Vert\) es el mayor autovalor de esta matriz. La matrix \((M^*M)^m\) tiene los autovalores \(\lambda^m\), y por esto, el máximo autovalor se consigue por $$\Vert M^*M\Vert=\lim_{m\to\infty}\bigl(\mathop{\rm tr}(M^*M)^m\bigr)^{1/m}.$$ El límite y la estimación de la traza de una potencia grande son inatacables. Por esto se quedan con la desigualdad $$(\Vert M^*M\Vert)^3\le\mathop{\rm tr}(M^*M)^3.$$ El exponente \(m=2\) no nos llevaría a una cota suficientemente pequeña. El exponente \(m=3\) es el primero que nos puede servir. Teniendo en cuenta la contribución de términos triviales llegan a que deben acotar $$\Bigl|\sum_{\substack{t_1,t_2,t_3\in W\\ |t_j-t_k|\ge T^\varepsilon}}\sum_{n_1,n_2,n_3\sim N}n_1^{i(t_1-t_2)}n_2^{i(t_2-t_3)}n_3^{i(t_3-t_1)}\Bigr|.$$ Todos los sumandos son de módulo unidad, de manera que se espera que muchos términos se cancelen. Transforman la suma en una integral, pero las técnicas usuales para acotar este tipo de sumas no llevan a buen puerto. Continuan la acotación de una manera no esperada.

Usar el análisis de Fourier.

Remito a las explicaciones de los autores. Aquí usan las diferencias sutiles que vienen de ser las frecuencias \(\log n\).

James Maynard y Larry Guth

Larry tiene ahora 47 años, es profesor en el MIT (Massachuset Institute of Mathematics), allí realizó su tesis, pero en el intermedio ha recorrido diversos centros importantes, Stanford, University of Toronto, Courant Institute. Ha recibido numerosos premios. Sus trabajos son muy diversos. Geometría métrica y combinatoria, análisis armónico. Por ejemplo, uno de sus trabajos trata de acotar las incidencias entre un conjunto \(P\) de \(n\) puntos y otro \(L\) de \(m\) rectas en el plano, el resultado clásico es el Teorema de Szemerédi y Trotter que acota este número por $$I(P, L)=O(m^{2/3}n^{2/3}+m+n).$$ Otro de sus temas es la desigualdad sistólica, que establece desigualdades entre la mínima longitud de una curva no contractible en un espacio \(M\) con métrica riemaniana y el volumen de \(M\).

Su interés en el problema es al menos de un año. Hay una conferencia suya en Junio de 2023 Discussion of Montgomery’s Large Value Problem, en el que expone las conexiones del problema con otros problemas de análisis armónico, como el problema de Restricción de la transformada de Fourier o el problema de Kakeya. En particular expone lo que llama el «Escenario enemigo». Se trata de que en el problema análogo, sustituyendo las frecuencias \(\log n\) por \(\sqrt{n/N}\), se obtiene un ejemplo en que lo que se quiere no es cierto. Con esto obtiene un conjunto de pequeñas diferencias entre los dos ejemplos que deben ser usados para cualquier mejora en nuestro problema. También que ciertas técnicas usadas en el problema de restricción de la transformada de Fourier, como los paquetes de ondas no son suficientes para avanzar en la conjetura de Montgomery. Él termina la conferencia diciendo «so we need new ideas«.

Esta conferencia por un lado me impresiona profundamente. Cómo Larry Guth busca un problema análogo, en que recientemente muchos matemáticos, como Bourgain o él mismo han hecho progresos notables. Analizando cómo esas técnicas se trasladan a la situación concreta de la conjetura de Montgomery y llegando al final a la conclusión de que se necesitan nuevas ideas. Recomiendo la visión de esta conferencia porque muestra la profundidad del análisis y como piensa una primera figura sobre un problema duro. Por otro lado, personalmente, la conferencia me deja deprimido sobre mis matemáticas.

James Maynard tiene 37 años, hizo la tesis bajo la dirección de Roger Heath-Brown en Oxford. La primera noticia que tuve de él fue cuando dio una nueva demostración del teorema de Yitang Zhang, demostrando que la distancia entre un primo y el siguiente \(p_{n+1}-p_n\) es menor que \(600\) para infinitos valores de \(n\). Después de esto ha obtenido numerosos resultados en teoría de números, por ejemplo, resolviendo una conjetura de Erdos sobre los mayores valores posibles de la diferencia \(p_{n+1}- p_n\) para \(p_{n+1}\le x\). En 2022 consiguió la Medalla Fields por sus trabajos en teoría analítica de números.

Para saber más

El trabajo que comentamos no es lectura fácil, pero tiene una primera parte en que tratan de explicar el resultado y dar una idea de la prueba.

Larry Guth y James Maynard, New Large Value Estimates for Dirichlet Polynomials, arXiv:2405.20552, (2024).

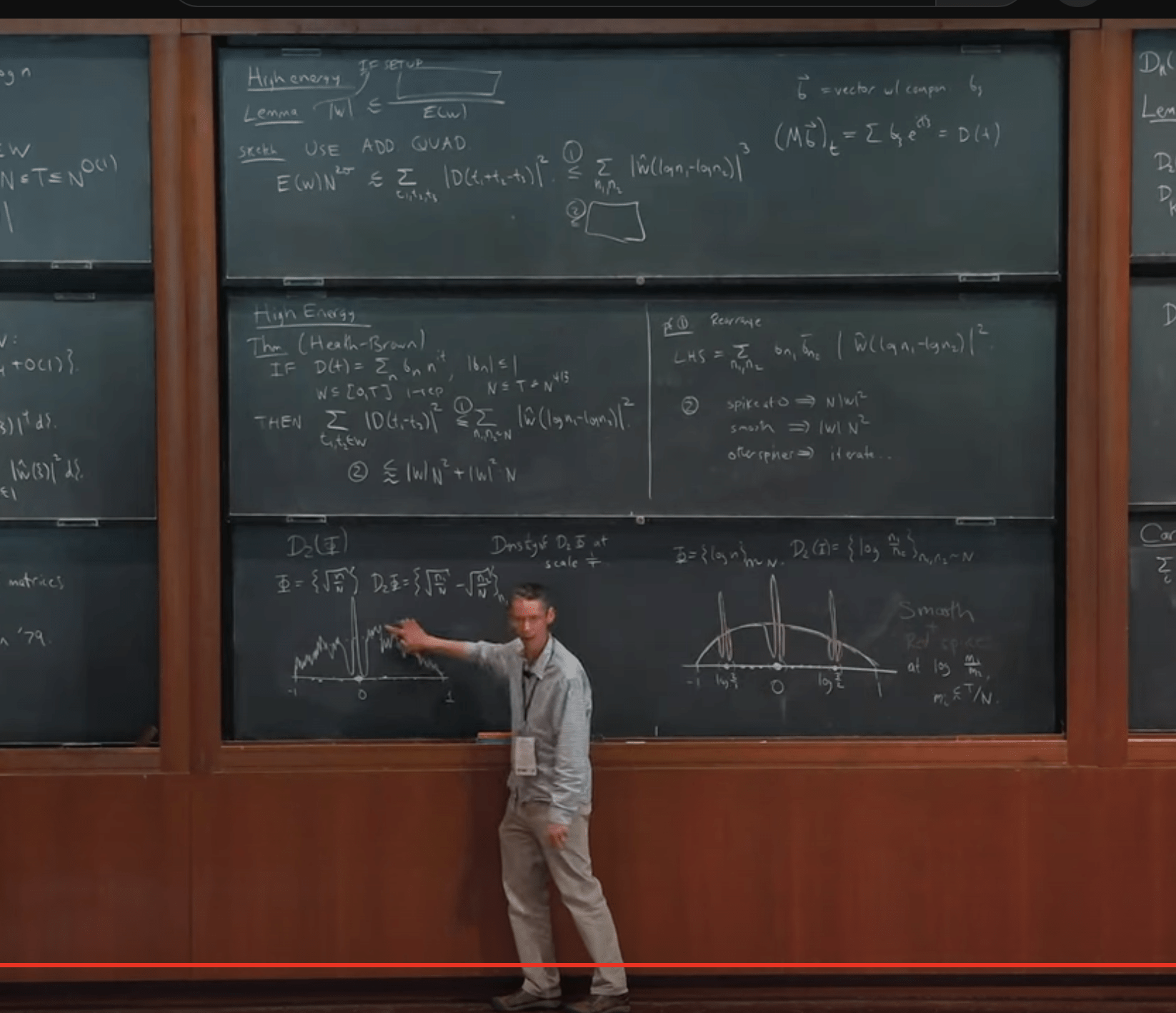

Hay dos conferencias en el Institute of Advanced Study en Princeton, la primera por James Maynard y la segunda por Larry Guth, explicando su resultado. Las dos son my recomendables y los he usado para escribir esta entrada.

New Bounds for Large Values of Dirichlet Polynomials, Part 1′ – James Maynard.

New Bounds for Large Values of Dirichlet Polynomials, Part 2 – Larry Guth.

Reitero que es muy interesante la exposición de Larry de la situación un año antes Discussion of Montgomery’s Large Value Problem.

La página web de Larry Guth tiene muchas cosas interesantes. En particular sus «Expository writing». Tiene explicaciones muy interesantes, por ejemplo, sobre lo que hoy día es la Geometría métrica.

No quiero dejar de mencionar los comentarios de Tao sobre este tema en Masthodon. Hay una entrada en Quanta sobre los resultados de James Maynard, anteriores al que nos ocupa, que pueden completar las pocas notas que he comentado antes sobre James.

La imagen destacada es de Larry Guth ante las pizarras del Instituto de Princeton, explicando su teorema.

Dejar una contestacion